Deepfakes erkennen: Tipps für Eltern und Lehrkräfte

In die Haut anderer schlüpfen und mit ihrer Stimme sprechen: Deepfakes machen es möglich. Was müssen Lehrkräfte und Eltern über die Technologie wissen? Wie können sie Kinder aufklären und schützen?

Letzte Aktualisierung: 08.09.2023

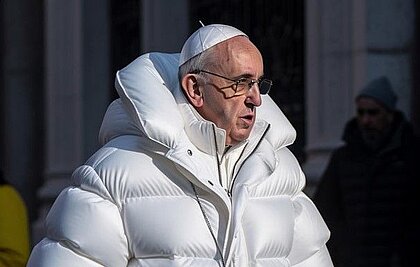

Der Papst in weißer Gangster-Daunenjacke – Russlands Präsident Wladimir Putin auf den Knien vor Chinas Staatspräsident Xi Jinping – Ex-US-Präsident Donald Trump bei der Verhaftung durch die Polizei: Diese Deepfake-Bilder aus dem Jahr 2023 gingen um die Welt. Doch nicht nur auf Fotos können reale Personen mithilfe von KI-Systemen täuschend echt nachgeahmt werden. Im Frühjahr 2022 wurde ein Deepfake-Video des ukrainischen Präsidenten Wolodymyr Selenskyj verbreitet, in dem er vermeintlich zur Kapitulation vor der russischen Armee aufruft. Dies zeigt, dass KI-Systeme inzwischen auch Bewegtbilder und Stimmen von echten Menschen überzeugend imitieren können.

Bekanntheit erlangte die Deepfake-Technologie bei Reddit (eine Art Online-Forum) im Jahr 2017, wo sich innerhalb kurzer Zeit eine Community bildete, die mit Hilfe einer Software in Videos Gesichter von Pornodarstellerinnen durch Gesichter von prominenten Schauspielerinnen tauschte. Die dahinterstehende Technik hat sich seitdem rasant weiterentwickelt und verbreitet. Im Jahr 2018 waren nur rund 14.000 Deepfake-Videos online – heutzutage existieren Milliarden von Deepfakes im Netz, die immer noch größtenteils dem Pornobereich zuzuordnen sind.

Dieses Spotlight beleuchtet, wie die Technologie funktioniert, welche Arten von Deepfakes es gibt und für welche Zwecke sie eingesetzt werden kann. In der Schule könnten sie zum Beispiel im Zusammenhang mit Cybermobbing relevant werden. Als Teil des Spotlights bieten wir daher Informationen, wie man Deepfakes erkennen und im Unterricht mit Kindern und Jugendlichen besprechen kann.

Zur Online-Fortbildung zum Thema Deepfakes am 27.09. anmelden

Workshop für Kinder und Jugendliche zum Thema Deepfakes anfragen

Unterrichtsmaterial zu Desinformation und Deepfakes herunterladen

Fragen zu konkreten Problemen mit Deepfakes im Klassenzimmer stellen

Mit dem KI-Bildgenerator Midjourney erstelltes Deepfake-Foto von Papst Franziskus in einer Gangster-Daunenjacke. | Foto: Reddit / KI-Bildgenerator Midjourney

Was sind Deepfakes?

Deepfakes sind Medieninhalte wie Fotos, Videos oder Audios, die mithilfe von künstlichen neuronalen Netzen so verändert oder komplett neu generiert wurden, dass sie nicht ohne Weiteres als Fälschung erkennbar sind. Um Deepfakes zu erstellen, braucht das zu trainierende Computermodell Daten der Zielperson (beispielsweise Bilder), um deren Gesichtszüge, Mimik und Bewegungen zu erlernen. Anschließend kann dieses Programm die Person mithilfe von künstlicher Intelligenz (KI) nachbauen und sie Sätze sagen und Dinge tun lassen, die in Wahrheit nie ausgesprochen wurden oder passiert sind. Andersherum können Gesichter in bestehenden Videos auch durch das Gesicht einer Zielperson ersetzt werden.

Durch die rasante Weiterentwicklung der Deepfake-Technologie in den letzten Jahren sind heutzutage verschiedene technische Manipulationen möglich. Hier stellen wir euch die bekanntesten Arten von Deepfakes kurz vor:

- Face-Swap: Der Klassiker – hier wird das Gesicht einer Person in einem Bild oder Video durch das Gesicht einer anderen Person ersetzt.

- Audio-Deepfake: Die Stimme einer Person wird synthetisch nachgestellt. So können Aussagen in Videos gefälscht werden.

- Puppet-Master: In einem Video wird die Mimik und Kopfbewegung der gezeigten Person manipuliert. Dafür werden die Gesten und die Stimme einer anderen Person auf die Person im Video übertragen.

- Lip-Syncing: Die Lippenbewegungen einer Person in einem Video werden manipuliert. Es entsteht der Eindruck, dass die Person die Worte spricht, obwohl sie tatsächlich von einer anderen Quelle stammen.

- Gesichtssynthese: Es werden künstliche realistische Gesichter erstellt, die es auf der Welt nicht gibt. Solche Gesichter können auf folgender Webseite abgerufen werden: https://thispersondoesnotexist.com/

US-Filmemacher Jordan Peele legte 2018 seine eigenen Worte in den Mund von Barack Obama und manipulierte dessen Mimik und Kopfbewegungen: Diese Art von Deepfake-Video nennt sich Puppet-Master. | Screenshot: BuzzFeed-Video vom 17.04.2018

Können Deepfakes auch positiv genutzt werden?

So vielfältig wie die Arten von Deepfakes, so vielfältig sind auch ihre Einsatzmöglichkeiten in Unternehmen und Gesellschaft. Insbesondere in den Bereichen Unterhaltung, Online-Handel, Marketing und Gesundheit birgt die Technologie das Potenzial, den Alltag von Menschen zu erleichtern und für immer zu verändern.

Unterhaltungsbranche: Mit Deepfakes Schauspieler/-innen verjüngen

Der Superheld im eigenen Videospiel sein, eine Schauspielerin ohne aufwendiges Make-up verjüngen oder die Stimme eines längst verstorbenen Sängers zum Leben erwecken: Mit der Deepfake-Technologie dürften bei der Produktion von Filmen, Musik und Videospielen in naher Zukunft nur wenige Wünsche offenbleiben. KI-Künstler/-innen zeigen bereits heute, wie mächtig die Technologie ist.

So überarbeitete der YouTuber Gideo Vames mithilfe der kostenfreien Software DeepFaceLab Szenen aus dem Netflix-Film „The Irishman“. In dem 2019 erschienen Streifen sind verjüngte Gesichter von Robert DeNiro, Al Pacino und Joe Pesci zu sehen. Während im Originalfilm digitale 3D-Modelle der Gesichter auf Basis von alten Filmaufnahmen und Fotografien verwendet werden, setzt der YouTuber auf Deepfake-Gesichter. Hierfür fütterte er die KI-Software mit tausenden Bildern der drei Schauspieler aus ihren jungen Jahren – und erzielte damit die lebendigeren und überzeugenderen Ergebnisse.

Trotzdem zögern Hollywoodstudios aktuell noch beim Einsatz der Deepfake-Technologie, da sie weniger berechenbar und kontrollierbar ist als digitale 3D-Modelle. Für die nahe Zukunft ist jedoch zu erwarten, dass die Deepfake-Technologie mit 3D- und Spezialeffekten kombiniert wird und die Filmbranche dadurch für immer revolutioniert wird.

Online-Handel: Mode virtuell anprobieren

Online-Shopping könnte in Zukunft noch zeitsparender und bequemer werden als bislang – nämlich dann, wenn Retouren weitgehend wegfallen. Mithilfe von Ganzkörper-Deepfakes könnten Kundinnen und Kunden das Outfit eines Katalogmodels selbst online anprobieren und an ihrem eigenen Körper bewundern – sich dabei drehen und wenden wie in der Umkleidekabine. Dadurch ließe sich schon vor dem Bestellen qualifiziert entscheiden, ob ein Outfit passt und gefällt. Ähnliche Möglichkeiten böten sich für den Bereich Frisuren und Haarfarben. Erstmals gelang es Wissenschaftlerinnen und Wissenschaftlern der Universität Berkeley im Jahr 2018, die Bewegungen eines professionellen Tänzers mittels Deepfake-Technologie auf einen fremden Körper übertragen zu lassen: Die Geburtsstunde des Ganzkörper-Deepfakes.

Marketing: Werbefilme mit Deepfake-Gesichtern prominenter Schauspieler/-innen

Doch nicht nur bei der Auswahl, auch bei der Bewerbung von Produkten wird künstliche Intelligenz in Zukunft eine entscheidende Rolle spielen. So müssen Prominente in Zukunft nicht mehr unbedingt selbst tätig werden, um für ein Produkt zu werben. Der Schauspieler Bruce Willis war im Jahr 2021 beispielsweise in Werbefilmen des russischen Mobilfunkanbieters Megafon zu sehen, für die er nie das Filmset betreten hatte. Ein russischer Schauspieler übernahm seine Rolle, dessen Gesicht via Deepfake durch das von Bruce Willis getauscht wurde. Trainiert wurde das Deepfake-Gesicht mithilfe von 34.000 Bildern des Schauspielers aus rund 40 Filmen.

Gesundheit: Stimmverlust rückgängig machen

Als Hilfsmittel im Gesundheitsbereich könnte die Deepfake-Technologie Menschen, die ihre Stimme durch eine Krankheit verloren haben, ein Stück Normalität zurückgeben. Das Unternehmen VocaLid hat sich zum Beispiel darauf spezialisiert, Stimmen auf Basis von Audioschnipseln und künstlicher Intelligenz zu konservieren. Die digitale Stimme, die mithilfe der Deepfake-Technologie imitiert wird, kann hinterher auf einem digitalen Endgerät gespeichert werden und per Spracheingabe in einer App ausgegeben werden.

Warum können Deepfakes gefährlich sein?

So faszinierend die positiven Einsatzzwecke von Deepfakes sind, so erheblich ist auch das Missbrauchspotenzial der Technologie – vor allem, wenn sie durch die Verbreitung von Deepfake-Apps in die Hände der Allgemeinheit fällt. Smartphones als Hilfsinstrument erlauben es dabei, heimlich Fotos und Videos von Personen im direkten Umfeld – ob Mitschüler/-in, Nachbar/-in, Kollege oder Kollegin – zu erstellen, die manipuliert werden können, um andere zu verleumden. Auch Betrugsstrategien und Desinformationskampagnen profitieren vom Einsatz von Deepfakes.

Verleumdung: Deepfakes als Steilvorlage für Cybermobbing an Schulen

Mit kaum einer anderen Technologie kann man dem Ansehen von öffentlichen oder privaten Personen so leicht Schaden zufügen wie mit Deepfakes. Mithilfe der Technologie können zum Beispiel glaubwürdige Fake-Pornos, gefälschte Social-Media-Profile oder Fake-Videos von kriminellen Handlungen erstellt werden. Diese können wiederum für Racheaktionen an Ex-Partnerinnen und Ex-Partnern oder zur Erpressung von mächtigen oder reichen Persönlichkeiten zum Einsatz kommen. Im Schulkontext ist damit zu rechnen, dass Kinder und Jugendliche Deepfakes für Cybermobbing einsetzen und es damit noch einfacher wird, Mitschüler/-innen oder auch Lehrkräfte bloßzustellen.

Mädchen und Frauen sind in besonderem Maße vom Missbrauch betroffen. Noch im Jahr 2021 waren laut Schätzung des Forschungsunternehmens Sensity AI 90 bis 95 Prozent aller im Internet kursierenden Deepfake-Videos Fake-Pornos – mit etwa 90 Prozent weiblichen Opfern. Während KI-Experte Henry Ajder für das Jahr 2018 14.000 Deepfake-Pornos im Netz zählte, könne ihre Zahl inzwischen nicht mehr erfasst werden und rangiere im Milliardenbereich. Betroffen sind längst nicht mehr ausschließlich prominente Schauspielerinnen, Sängerinnen oder Politikerinnen. In Bilderforen und Tauschbörsen im Netz werden inzwischen massenhaft und ungefragt Bilder von unbekannten Mädchen und Frauen hochgeladen, die bereits gedeepfaket wurden oder gedeepfaket werden sollen.

Betrug: Mit Stimmen- und Gesichtsklonen Geld erbeuten

Wie ein prominenter Fall aus dem Jahr 2019 zeigt, eignet sich Deepfake-Technologie auch hervorragend, um Betrugsmaschen im Unternehmens- und Privatbereich auf eine neue Ebene zu heben. So tätigte der Geschäftsführer eines britischen Energieunternehmens eine Überweisung in Höhe von 243.000 US-Dollar auf das vermeintliche Bankkonto eines ungarischen Lieferanten, nachdem er mit der Fake-Stimme des Vorstandsvorsitzenden der deutschen Muttergesellschaft telefoniert hatte. Ein Betrüger hatte zur Nachahmung der Stimme eine KI-Sprachsoftware verwendet.

Um überzeugende Stimmenfakes mit Software wie „Murf“, „Resemble AI“ oder „Respeecher“ zu generieren, reichen inzwischen einige Sprachschnipsel z.B. aus sozialen Netzwerken oder Messengern aus. Der altbekannte „Enkeltrick“, bei dem Großeltern aufgrund einer vermeintlichen Notsituation ihrer Enkelkinder um Geldüberweisung gebeten werden, könnte durch Stimmenklone zum „Enkeltrick 2.0“ werden. Im Banken- und Versicherungsbereich könnten Gesichts- und Stimmenklone ebenfalls problematisch werden. In Echtzeit laufende Deepfake-Stimmen oder Deepfake-Videos von Privatpersonen könnten hier dazu genutzt werden, um biometrische Systeme der Stimm- oder Videoidentifikation zu überwinden.

Desinformation: Mit Deepfakes gegen Minderheiten hetzen

„Ein Bild sagt mehr als tausend Worte“ – Maßgeschneiderte Fotos und Videos für jede Fake-News-Meldung im Netz könnten in Zukunft die Verbreitung und Glaubwürdigkeit von Desinformationen nochmals erhöhen. In Deutschland nutzen zum Beispiel Mitglieder der Partei Alternative für Deutschland (AfD) bereits heute KI-generierte Fotos, um Ängste vor Geflüchteten zu wecken. So veröffentlichte der stellvertretende AfD-Fraktionsvorsitzende im Deutschen Bundestag, Norbert Kleinwächter, im Frühjahr 2023 ein Deepfake-Foto auf seinem Instagram-Kanal. Es zeigt einen „Mob“ von wütenden dunkelhaarigen Männern mit aufgerissenen Mündern und zornesverzerrten Gesichtern gemeinsam mit dem Aufruf „Nein zu noch mehr Flüchtlingen!“ Eine Hand mit sechs Fingern auf dem Foto verrät unter anderem die Fälschung.

Ebenfalls hohe Wellen schlug im Frühjahr 2023 ein Deepfake-Video des Komikers „Snicklink“, in dem Bundeswirtschaftsminister Robert Habeck im Zusammenhang mit dem Bundesheizungsgesetz vermeintlich despektierlich über die mögliche Insolvenz von „ein paar Bäckern und Ramschhändlern“ spricht und der TV-Moderatorin Sandra Maischberger das Wort verbietet. Erst im letzten Teil des Videos ist es klar als satirisch erkennbar. Werden politische Deepfakes wie diese massenhaft verbreitet, könnte es in der Zukunft laut Computerwissenschaftler Aviv Ovadya zu einem Szenario der allgegenwärtigen Desinformation führen: einer „Infokalypse“. In diesem Szenario stünden alle Medieninhalte und alle markanten Aussagen von öffentlichen Personen unter einem allgemeinen Fälschungsverdacht. Deepfakes könnten dann wiederum als Ausrede, zum Beispiel für tatsächlich getätigte kriminelle Handlungen, genutzt werden.

Ein aktueller Schadensersatzprozess gegen Tesla-Chef Elon Musk wegen eines tödlichen Unfalls mit einem autonom fahrenden Tesla zeigt, dass dieses Szenario bereits Realität geworden ist. Musks Anwälte behaupten in diesem Prozess, ein Beweisvideo der Anklage aus dem Jahr 2016 sei ein Deepfake. Im besagten Video äußerte Elon Musk, dass die Tesla-Modelle S und X bereits zum damaligen Zeitpunkt „autonom und sicherer fahren könnten als eine Person“. Die Tatsache, dass das Video ein Mitschnitt eines renommierten US-Mediums von einer Live-Veranstaltung mit Publikum ist und dass im Jahr 2016 noch keine perfekten Deepfake-Videos generiert werden konnten, sprechen jedoch klar gegen diese Behauptung.

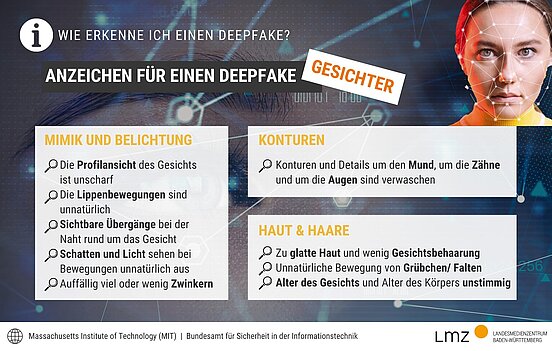

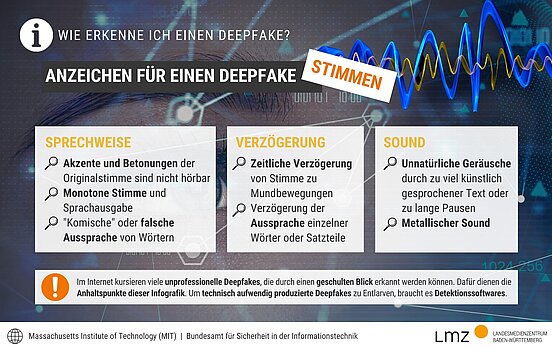

Wie erkenne ich Deepfakes?

Im Internet oder den sozialen Medien finden sich momentan noch viele nicht ganz professionell erstellte Deepfakes, die gewisse Anhaltspunkte für ihre Fälschung liefern und durch einen geschulten Blick erkannt werden können. Das Massachusetts Institute of Technology (MIT) sowie das Bundesamt für Sicherheit in der Informationstechnik haben mehrere Tipps veröffentlicht, um KI-generierte Bilder und Videos zu entlarven.

Tipps für Eltern & Lehrkräfte

Um Kinder und Jugendliche auf den Umgang mit Deepfakes vorzubereiten, müssen sie ein Verständnis dafür entwickeln, dass mithilfe von künstlicher Intelligenz heutzutage täuschend echt aussehende Fotos, Videos und Audios von jeder beliebigen Person erstellt werden können. Anhand einschlägiger Gesetze sollte verdeutlicht werden, dass Bild- und Audiomaterial anderer Personen nicht ohne deren Zustimmung erstellt, verarbeitet und verbreitet werden darf. Mit dem zugehörigen Handwerkszeug sollten Schüler/-innen außerdem selbst lernen, Fotos, Videos und Audioaufnahmen auf ihre Echtheit hin zu überprüfen.

Um möglichst nicht selbst Opfer von Deepfakes zu werden, können Kinder und Jugendliche sowie deren Eltern einige Vorsichtsmaßnahmen treffen:

- Die Privatsphäre-Einstellungen der eigenen Social-Media-Kanäle regelmäßig kontrollieren und genau überlegen, mit welchen Personen man private Fotos und Videos teilen möchte. Je mehr Fotos und Videos online sind, desto größer ist die potenzielle Gefahr des Missbrauchs.

- Auf vermeintlich privaten Messengern wie WhatsApp beachten, dass z.B. im Status mit allen Kontakten geteilte Fotos und Videos auch unerwünschte oder unbekannte Personen sehen können, die die eigene Telefonnummer gespeichert haben. Um dieses Problem zu umgehen, kann der Status zum Beispiel nur mit ausgewählten Kontakten geteilt werden.

- Eine regelmäßige Google-Rückwärtssuche mit eigenen Fotos kann Aufschluss darüber geben, wo diese im Netz verbreitet werden. Bei Missbrauch oder unerwünschter Verbreitung kann anschließend eine Löschung erwirkt werden. Achtung: Um Kinder und Jugendliche zu schützen, sollten jedoch ausschließlich Eltern dieses Instrument für ihre Kinder nutzen.

Auch Kinder und Jugendliche können Opfer von Deepfakes werden und sollten daher früh mit der Technologie vertraut gemacht werden. | guruXOOX/iStock/Getty Images Plus via Getty Images

Wie ahmt eine KI einen Menschen nach?

Orientiert am menschlichen Gehirn sind beim Deep Learning künstliche neuronale Netze miteinander in Schichten verbunden. Neuronen im menschlichen Gehirn sammeln Signale aus umliegenden Zellen, stufen diese nach Wichtigkeit ein und entscheiden anschließend selbst, ob sie mit einem eigenen Signal reagieren oder nicht. Analog dazu besitzen künstliche neuronale Netze eine Input-, eine Zwischen- und eine Output-Ebene. Auf der Input-Ebene werden zum Beispiel Fotos von Tieren analysiert, die auf der Output-Ebene als Hund oder Katze kategorisiert werden. Mithilfe von riesigen Datensätzen trainieren sich künstliche neuronale Netze selbst und lernen, komplexe Muster und Merkmale in Daten zu erkennen, z.B. dass Schnurrhaare und ein hochstehender langer Schwanz typisch für eine Katze sind.

Der Einsatz von Deep Learning-Algorithmen ermöglicht es, Beispiele auszuwerten und Problemlösungen zu finden. Auf Basis dieser Technologie lassen sich aber auch realistische Deepfakes erstellen. Unabhängig von der Art des Deepfakes – visuell oder auditiv – besteht der Erstellungsprozess aus drei Phasen:

- Datenextraktion: Autoencoder sind KI-Modelle, die aus einem Encoder-Part und einem Decoder-Part bestehen. Der „Encoder“ analysiert das Gesicht einer Person anhand von Bildmaterial und liest biometrische Daten und Merkmale aus. Je mehr echte Daten einer Person das Programm erhält und je mehr qualitativ hochwertiges Bildmaterial verwendet wird, desto realistischer wirkt das Ergebnis. Bei einem Input von rund 300 Bildern und aufwärts gelingt ein erschreckend realistischer Fake.

- Modelltraining: Im zweiten Schritt lernt das künstliche neuronale Netzwerk anhand aller eingegebenen Daten die Gesichtsmerkmale und Ausdrücke einer Person, sodass es das Gesicht replizieren kann. Dieser Trainingsprozess dauert in der Regel stundenlang, um einen richtig guten Deepfake zu erzeugen. In einem letzten Schritt steht die Verarbeitung an.

- Konvertierung: Der „Decoder“ wandelt abschließend die Informationen aus den analysierten Daten zu einem künstlich nachgeahmten Gesicht um. Soll beispielsweise ein Gesicht in einem Video mit einem anderen getauscht werden, braucht man zwei Encoder und zwei Decoder. Der Merkmalssatz von Gesicht 1 wird dann mit Decoder 2 verknüpft. So kann auf dem ursprünglich im Video zu sehenden Gesicht 1 das Gesicht 2 der Zielperson rekonstruiert werden.

Zur Erstellung von Deepfakes gibt es neben Autoencodern die Möglichkeit, Generative Adversarial Networks (GANs) zu verwenden. GANs arbeiten mit zwei konkurrierenden neuronalen Netzwerken, die sich in puncto Merkmalsreplikation permanent gegenseitig verbessern.

Beim Deep Learning analysiert der Encoder zunächst das Gesicht einer Person anhand von Bildmaterial und liest biometrische Daten aus. | Prostock-Studio/iStock/Getty Images Plus via Getty Images

Wie kann ich selbst einen Deepfake erstellen?

Deepfakes lassen sich heutzutage mit frei verfügbaren Apps oder Software schon in wenigen Minuten erstellen. Die Technologie dahinter funktioniert dabei wie oben beschrieben. Im Gegensatz zu professioneller Software kommen diese KI-basierten Apps und Computerprogramme jedoch mit sehr viel weniger Bild- oder Ton-Material aus und erstellen inzwischen trotzdem Deepfakes mit hinreichender Qualität.

- Reface ist ein Beispiel für eine bekannte App für Face-Swaps. Mit nur einem Selfie können Nutzer/-innen ihr Gesicht auf verschiedene Charaktere projizieren. Sekundenschnell erfasst Reface deren Gesichtszüge und tauscht diese mit dem gewünschten Charakter aus – als Bild oder Video.

- Die Software DeepFaceLab wiederum ist nicht so niederschwellig nutzerbar wie Reface. Die KI hinter DeepFaceLab braucht mehrere Stunden, um mit den hochgeladenen Daten und dem Material zu trainieren, erzielt aber dafür auch die besseren Ergebnisse.

- Ein Beispiel für eine Sprachgenerierungs-App ist VoiceCopyAI. Hier müssen Sie einfach eine Trainings-Datei (Video oder Memo) mit der gewünschten Stimme hochladen – den Rest erledigt die App. Ihr erfundener Text wird dann von der Wunschstimme vorgelesen.

Achtung: Wer Deepfake-Apps im Unterricht ausprobieren möchte, sollte den Datenschutz beachten. Unsere Empfehlung wäre es, die Apps nur mit fiktiven Gesichtern der Webseite thispersondoesnotexist.com zu verwenden und nicht das eigene Gesicht abzuscannen. Grundsätzlich sind Deepfakes mit datenschutzrechtlichen Problemen verknüpft.

Um das Aussehen einer Person auf einem Foto oder Video zu verändern, gibt es neben der Deepfake-Technologie noch andere technische Möglichkeiten wie zum Beispiel Filter. In den sozialen Netzwerken sind sie beliebt, da sie das Gesicht „verschönern“, in ein Tier verwandeln oder verjüngen können. Diese Filter basieren ebenfalls auf KI und haben durch das Training mit einer Vielzahl von Vorher-Nachher-Bildern zum Beispiel gelernt, wie sich professionell „verschönerte“ Bilder von Originalen unterscheiden. Im Unterschied zur Deepfake-Technologie werden jedoch nur einzelne Merkmale eines Gesichts verändert, während bei Deepfakes das komplette Gesicht einer Person inklusive seiner Mimik von der KI nachgebaut wird.

Die De-Aging-Technologie nutzt computergenerierte Effekte, um Schauspieler/-innen zu verjüngen oder altern zu lassen. Anders als bei Deepfakes werden nur einzelne Merkmale verändert und das Gesicht nicht komplett neu von einer KI nachgebaut. | master1305/iStock/Getty Images Plus via Getty Images

Sind Deepfakes in Deutschland legal?

Während in Australien und voraussichtlich in Zukunft auch in Großbritannien nicht einvernehmliche Deepfake-Pornografie unter Strafe steht, unterscheidet Deutschland bislang nicht in einer gesonderten Gesetzgebung zwischen legalen und kriminellen Deepfakes. Doch bestehende Rechte und Gesetze schützen Bürger/-innen bereits jetzt vor dem willkürlichen Missbrauch mit Deepfakes. Dazu zählen:

- Artikel 1 des Grundgesetzes: Schutz der Menschenwürde

- Strafgesetzbuch Paragraf 201a: Recht am eigenen Bild

- Strafgesetzbuch Paragraf 184b: Verbreitung, Erwerb und Besitz kinderpornografischer Inhalte

- Strafgesetzbuch Paragraf 185: Beleidigung

- Strafgesetzbuch Paragraf 187: Verleumdung

- Gesetz über Urheberrecht Paragraf 97: Beseitigungsanspruch

- Netzwerkdurchsuchungsgesetz (NetzDG)

- Datenschutzgrundverordnung (DSGVO)

Außerdem arbeitet die EU-Kommission derzeit an einem umfassenden KI-Gesetz, das KI-Systeme je nach Risiko für Individuen und Gesellschaft mit Regeln oder Verboten belegen möchte. Inwiefern jedoch all diese Rechte und Gesetze in der polizeilichen und juristischen Praxis tatsächlich zur Anwendung kommen, steht auf einem anderen Blatt. Zu den erschwerenden Faktoren gehören, dass Deepfakes häufig anonym im Internet veröffentlicht werden, ein dauerhaftes Löschen oft an Privatkopien scheitert und Expertenwissen sowie Detektionssoftware zum Identifizieren erforderlich ist.

Justizia ist auch im Internet aktiv: Die Menschenwürde, das Recht am eigenen Bild und weitere Schutzrechte gelten auch für Deepfakes. | Ulf Wittrock/iStock/Getty Images Plus via Getty Images

Lernideen zum Thema Künstliche Intelligenz in der SESAM-Mediathek

| Lasst uns die Zukunft der Schule gemeinsam mitgestalten! | Zur Lernidee |

| KI als Gesprächspartner - Personen aus der Berufs- und Arbeitswelt befragen | Zur Lernidee |

| Fake News mit KI-Bildgeneratoren erstellen und erkennen | Zur Lernidee |

| Storytelling mit KI | Zur Lernidee |

| Fachtexte mithilfe einer Text-KI erschließen | Zur Lernidee |

| KI zur Verbesserung von Erörterungen einsetzen | Zur Lernidee |

| Interpretation eines von einer KI geschaffenen Werks | Zur Lernidee |

| Vorurteile und Stereotype in KI-Systemen aufdecken | Zur Lernidee |

| KI-Texte mit Texten von Menschen vergleichen | Zur Lernidee |

| Wir schreiben queere Zukünfte | Zur Lernidee |

| Erstellen von Texten mit einer Text-KI durch zielführendes Prompt-Writing | Zur Lernidee |

| KI als Gesprächspartner - ein Vorstellungsgespräch simulieren | Zur Lernidee |

| Individuelle Übungsaufgaben zur Prüfungsvorbereitung mit Text-KI erstellen | Zur Lernidee |

| Game-Design mit KI | Zur Lernidee |

| KI als Assistenz bei der Präsentationserstellung | Zur Lernidee |

| Bildbeschreibung üben & sprachliche Phänomene vertiefen mit KI | Zur Lernidee |

| Bewerbungsprozess: Mega-Prompting & Algorithmische Diskriminierung | Zur Lernidee |

| Schlau oder weniger schlau? | Zur Lernidee |

| Glaubwürdig oder nicht glaubwürdig? | Zur Lernidee |

| Interessen erkennen - Interessen hinterfragen | Zur Lernidee |

| FUTURE ME – Eine Konversation mit dem zukünftigen Ich | Zur Lernidee |

Weitere Unterrichtsmaterialien & Tools

Für Ihre nächste Unterrichtsstunde zum Thema Deepfake haben wir hier eine Reihe von Unterrichtsmaterialien, Tools und Erklärvideos zusammengestellt:

Unterrichtsmaterial von Bitte Was?! (2022): Desinformation in den sozialen Medien

Planspiel von Klickwinkel: DeepFakes: Was ist noch echt?

Unterrichtsmaterial der BR-Sendung So geht Medien (2020): Deepfakes

Fraunhofer Institut: Tool, um Audioaufnahmen auf Echtheit zu prüfen

Lernbilder von Deutsche Welle (2022): Wie erkenne ich einen Deepfake?

Romy Göhner & Madeleine Hankele-Gauß

Diese Seite teilen: